Ici, nous allons nous poser les problèmes tels qu’ils ont été rencontrés dans l’Histoire des cinquante dernières années, et nous allons apporter la réponse qui a été trouvée, et montrer ainsi l’évolution de la technologie, pour répondre aux besoins des utilisateurs :

- L’évolution de l’oscillateur.

- Le changement de récepteurs.

- Le besoin de connecter les ordinateurs entre eux.

1. L’évolution de l’oscillateur.

Jusqu’à il y a 50 ans, on utilisait pour calculer l’heure un oscillateur de type pendule, c’est-à-dire un file au bout duquel était suspendue une boule. Lorsque le fil faisait la bonne longueur, le pendule battait la seonde. Mais cela posait un problème ; il fallait entretenir le mouvement. Pour cela, on utilisait des poids, comme dans cete vidéo :

https://youtu.be/3yz6L2ElP74

Mais ceci, c’était jusqu’à il y a 50 ans. Le mouvement pouvait même être sur des horloges de poignet, car même s’il était de 10 battements par seconde, on pouvait facilement retrouver la seconde par des divisions.

Le problème majeur des pendules est que leur précision est de l’ordre de l’unité, c’est-à-dire de la seconde. Si le pendule fait une erreur d’une unité, l’heure se décale d’une seconde. Mais, imaginons une mesure faite au dixième de seconde. À ce moment-là, si on fait une erreur d’une unité, l’erreur est moins grande, car c’est une erreur d’un dixième de seconde (voir les images ci-dessous).

L’idée est alors née de parvenir à trouver l’heure grâce à une fréquence très élevé, pour augmenter la précision. En effet, quand on utilise une règle précise au millimètre, c’est déjà précis. Mais, en utilisant les palers, précis au dixième de millimètre, on est encore plus précis. En augmentant la précision, on augmente la fréquence. Il a fallu changer de référence. On n’a plus utilisé un balancier, qui est soumis à des problèmes d’altitudes, de longitude, de température (le fil s’allonge), mais on a trouvé autre chose. On a mesuré à partir de la fréquence de l’atome de césium 135. On se base sur un changement d’état du Césium, ce qui permet d’avoir une fréquence extrêmement élevée, de l’ordre de neuf milliards de Hertz.

Notons tout de même que l’intermédiaire du quartz était un progrès technique très important pour l’époque, car on comptait une oscillation de l’ordre de 32 000 000 battements par seconde.

2. Le changement de récepteurs.

Cependant, dès que l’on fait une mesure sur une particule à l’état atomique, on ne peut plus le faire dans une montre. Il est impossible d’effectuer cette mesure chez soi. Il faut donc qu’il y ait une diffusion de l’heure, et cela se fait par l’intermédiaire de la radio. Le principe reste simple : l’horloge atomique de Francfort émet l’heure, et il y a des récepteurs radio. Quand on regarde comment étaient faits les postes de radio à l’époque, c’était énorme. Il y avait beaucoup de lampes, que l’on appelle des nixies. Il y a des plaques éloignées les unes des autres, et les électrons passent de l’une à l’autre.

Pour résumer, le principe reste le même. Cependant, on utilise des outils très consommateurs en courant électrique, jusqu’à ce que l’on ait des afficheurs à DEL, puis à cristaux liquides :

Dans les années 50, un américain a quelqu’un qui a eu d’utiliser des transistors, et on obtint un gain considérable de place.

En 1973, on a pu fabriquer un poste de radio avec des transistors. Le système nécessitait 6 transistors, mais aussi des condensateurs, des résistances… :

|

Pour la première fois, en 1973, la revue « Le haut-parleur » publie, dans son numéro 1396 daté du 15 mars, la description d’un récepteur de signaux horaires. Nous en avons extrait l’article de 3 pages : Article du Haut-Parleur N° 1396 du 15 mars 1973 |

Ça marchait, mais ça prenait toujours beaucoup de place pour simplement recevoir la radio.

Le poste à lampes était tout de même une évolution majeure. C’étaient de gros blocs, avec beaucoup de boutons. Ces postes sont les équivalents de notre antenne que nous verrons dans la page suivante. Maintenant, tous les éléments ont été miniaturisés pour pouvoir rentrer dans une montre.

3. Le besoin de connecter les ordinateurs entre eux.

Au cours des 40 dernières années, la mesure du temps à changée radicalement de méthode : la seconde a longtemps était l’unité de mesure ; en utilisant un oscillateur plus rapide, on augmente la précision de la mesure.

Cependant, l’évolution technique majeure du XXème siècle est l’apparition des ordinateurs. Cela va transformer considérablement la société.

Mais cela ne s’est pas fait d’un seul coup. Au début, les ordinateurs que l’on pouvait voir, c’était les calculatrices. Puis, il y a eu les calculatrices programmables, et enfin les ordinateurs dans les universités.

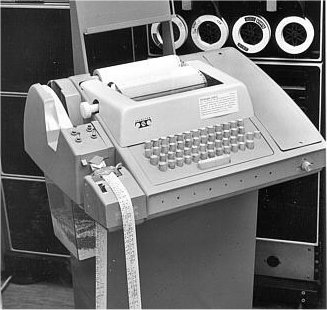

Puis, un homme aux États-Unis s’est dit qu’il était possible de créer les mêmes outils que dans les universités, mais à destination du grand public. C’est la naissance des premiers ordinateurs personnels, les PC (personal computer), au début des années 1980. Ni les écrans ni les claviers n’étaient reliés aux ordinateurs. On utilisait des cartes perforées pour donner des instructions, et on utilisait une machine à écrire électrique pour lire la réponse :

|

|

Ces PC ressemblent beaucoup aux ordinateurs qui existent aujourd’hui. Mais il y avait deux lecteurs de disquettes supplémentaires, qui étaient très gros. Quand on voulait initialiser l’ordinateur, il fallait mettre une disquette, l’allumer, puis l’ordinateur allait chercher sur la disquette ce qu’il devait faire. Mais cela était extrêmement long. Tout ça pour un simple logiciel, qui permettait à n’importe qui de développer de simples programmes.

Parallèlement, à l’université, les étudiant qui avaient accès aux logiciel UNIX, eux, ont travaillé en collaboration. Ils ont voulu essayer de faire passer des informations d’un ordinateur à un autre. Et pour cela, on a utilisé des téléphones. C’était la meilleure manière de se relier à l’époque. C’est la DARPA (Defense Advanced Research Projects Agency) qui finançait ce travail de mise en réseau. Au début, le premier réseau s’est appelé « arpanet », puis « réseau arpa ». Et ce réseau fonctionnait par téléphone. Mais de vieux téléphone, en bakélite, noirs, très lourds. On travaillait des coupleurs acoustique : d’un côté on mettait le haut-parleur du premier téléphone, de l’autre le micro, et on les tournait de telle sorte que les coupleurs acoustiques soient en face des micros. Pour faire passer l’information là-dedans, il fallait qu’elle soit codée en binaire, et que ça passe par le téléphone. Mais le téléphone, c’était fait pour transmettre de la voix, et pour être écouté. Il a donc fallu moduler, c’est-à-dire qu’en partant des tops, et on fabriqué des fréquences. Ainsi, une fois modulée, on a obtenu des sons graves ou aigus, que l’on pouvait transférer par téléphone. Et de l’autre côté, le téléphone entendait, et le micro du coupleur acoustique démodulait le message reçu. C’est un système moduleur-démoduleur. C’est ce que l’on appelle aujourd’hui le modem, ou mo-dem, pour moduleur-démoduleur.

Plus tard, ce système a été remplacé par un système numérique. On numérise le son directement. Donc, on a fait du transfert par téléphone, mais sans les coupleurs acoustiques. Il faut comprendre que les coupleurs acoustiques à l’époque ne permettaient pas de faire passer beaucoup d’informations ; c’était de l’ordre de 300 Bo (300 bits par seconde). Aujourd’hui, on fait passer de l’information à une vitesse de l’ordre du GBo (giga bo). Il fallait être passionnant pour un petit message. On a donc voulu aller plus vite, et on a décidé de remplacer les fils en cuivre par de la fibre de verre. Cela permettait d’augmenter la bande passante dans ces fils. Ceci a été une grande révolution : tant qu’on en était à passer par le téléphone, on mettait les machines à l’heure à la main. Après, elles ont été connectées en permanence, ou quasiment. En effet, quand l’ordinateur est éteint, il fonctionne grâce à un principe de mémoire, que l’on détaillera plus tard dans la démarche. C’est donc dans les années 1985 que l’on a mis en place un protocole de réseau pour mettre en place les ordinateurs.

La dernière étape a été de relier les ordinateurs entre eux. A l’époque, on ne pouvait utiliser que des communications filaires. Pour reconnaître les ordinateurs, il fallait un numéro d’identification, composé de 4 octets. C’est la norme IPV4, qui offre des adresses sous la forme 192.168.0.3, avec entre les points des nombres allant de 0 à 255. Cependant, très vite, le compte n’était pas suffisant, et l’adresse sous la forme maximum de 255.255.255.255 ne serait pas la dernière utilisée. On a donc dû développer une nouvelle forme : l’IPV6, avec 6 octets. Le nombre d’adresses possibles est alors supérieur au nombre de molécules sur Terre.

L’objectif d’attribuer une adresse à chacun était donc atteint. En allumant son ordinateur, on peut voir qu’il a une adresse. Maintenant, tous les objets fabriqués avec de l’électronique ont une adresse. Et ils communiquent entre eux. Donc, ils se remettent à l’heure. C’est la dernière phase d’évolution.

Nous nous sommes intéressés à la mise à l’heure des ordinateurs, mais l’évolution de la technologie ne s’arrête pas là. Les objets eux mêmes communiquent pour se mettre à l’heure. Le téléphone par exemple, ou le four… D’ici peu, il n’y aura plus besoin de les remettre à l’heure, par exemple après une panne de courant, car ils communiqueront par internet, avec les adresses IPV6.